그람-슈미트 직교화 (Gram–Schmidt Orthogonalization)

먼저, Gram-Schmidt Orthogonalization, 왜 배우는 걸까?

feature 간 수직 (Orthogonal)이 되지 않으면 중복된 정보를 추출하게 된다.

-> linearly independent 한 feature를 Orthogonal 하게 만들자!

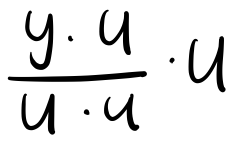

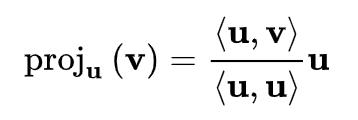

이전 글(Orthogonal Projection)에 포스팅한 마법의 공식, 다시 등장한다. projection 의 공식이다. 위키피디아에서는 사영 연산자를 다음과 같이 정의한다.

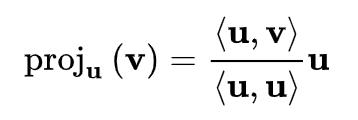

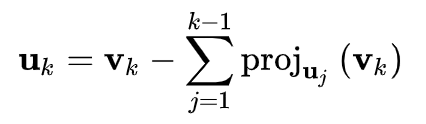

그람-슈미트 과정의 일반화 된 공식은 아래와 같다. 이 공식을 도출해보자.

예제

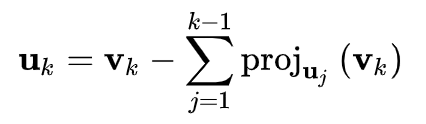

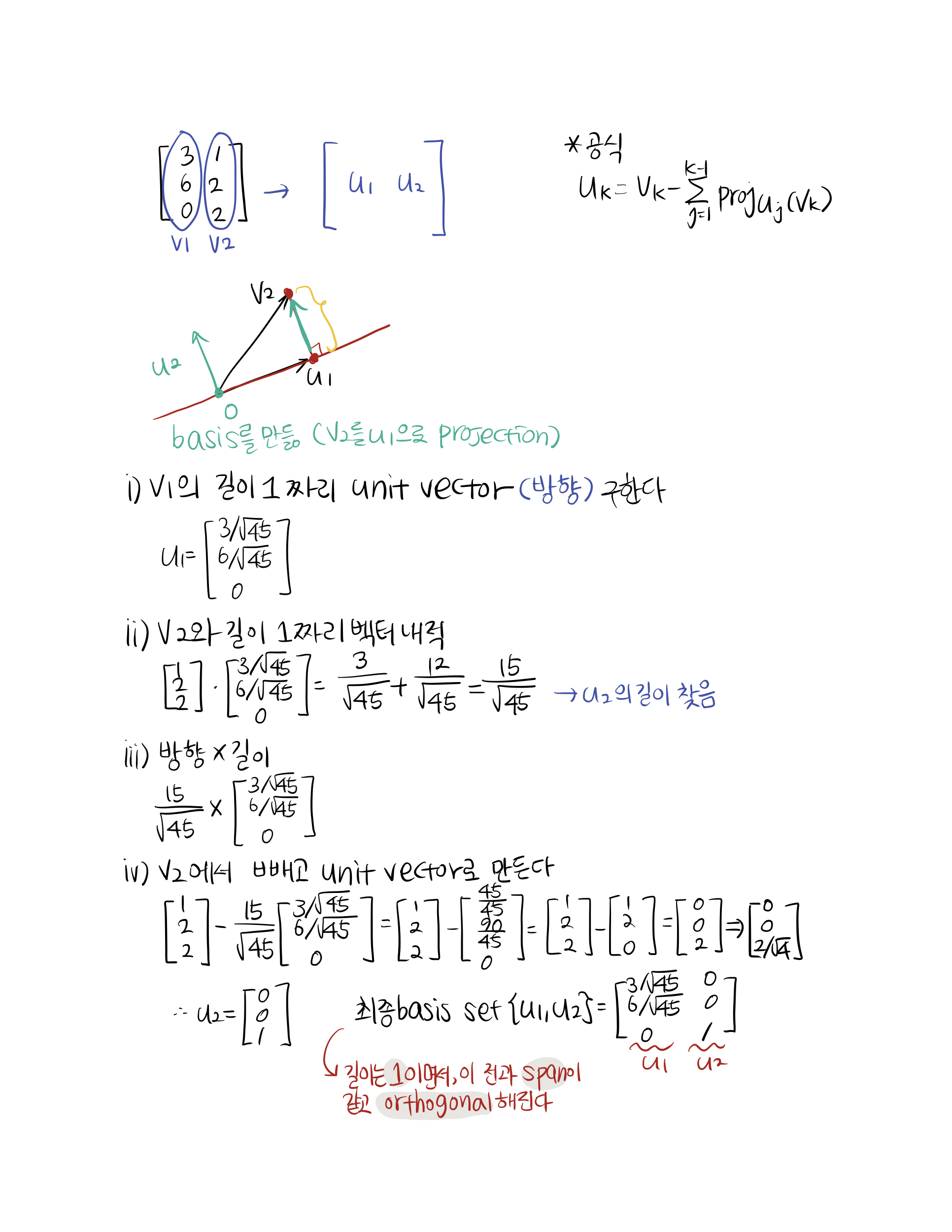

먼저 2차원에서는 쉽다.

Let W = span{v1, v2}, where v1 = [3,6,0].T and v2 = [1,2,2].T 일 때 W에 orthogonal basis {u1, u2} 를 만들어보자.

공식에 대입해도 바로 나온다.

예제

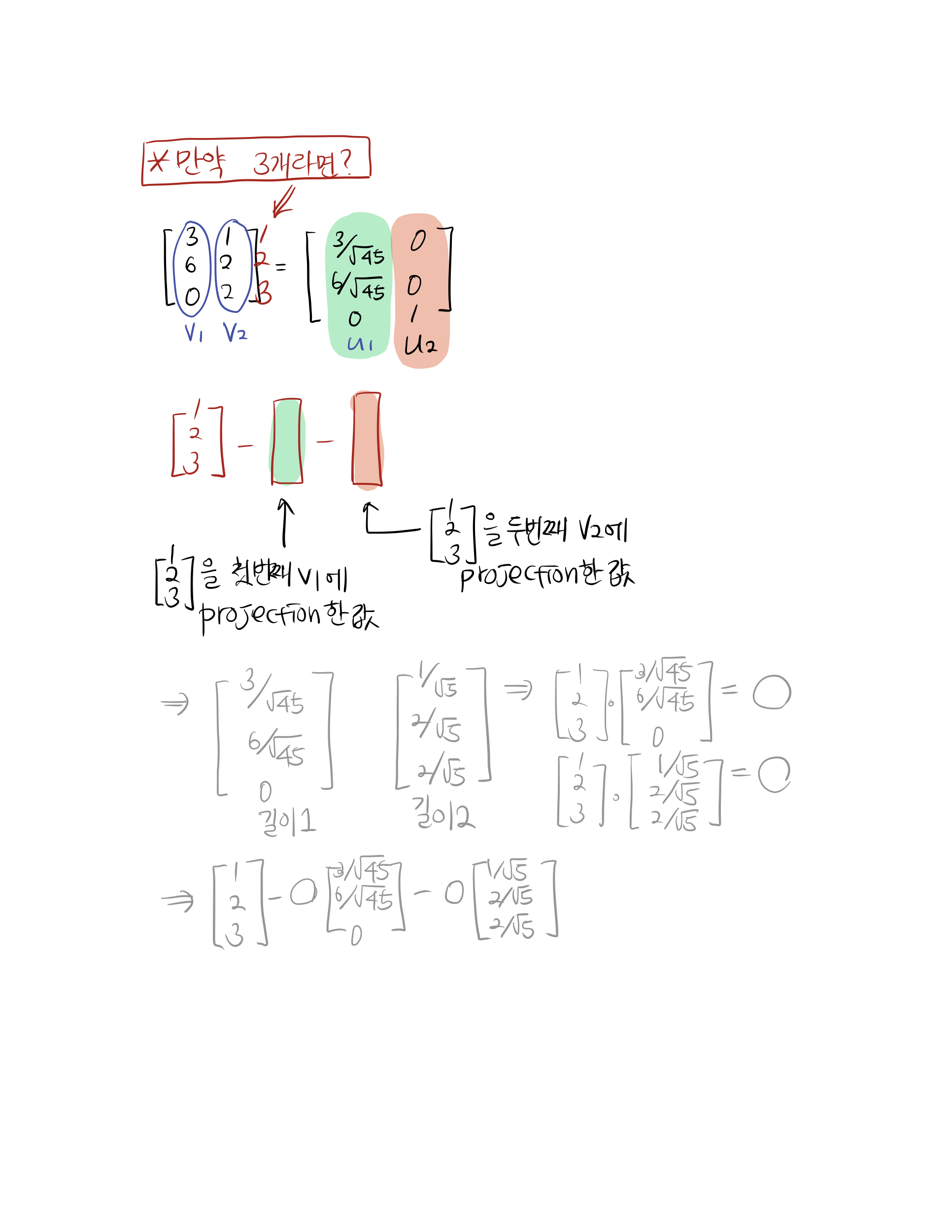

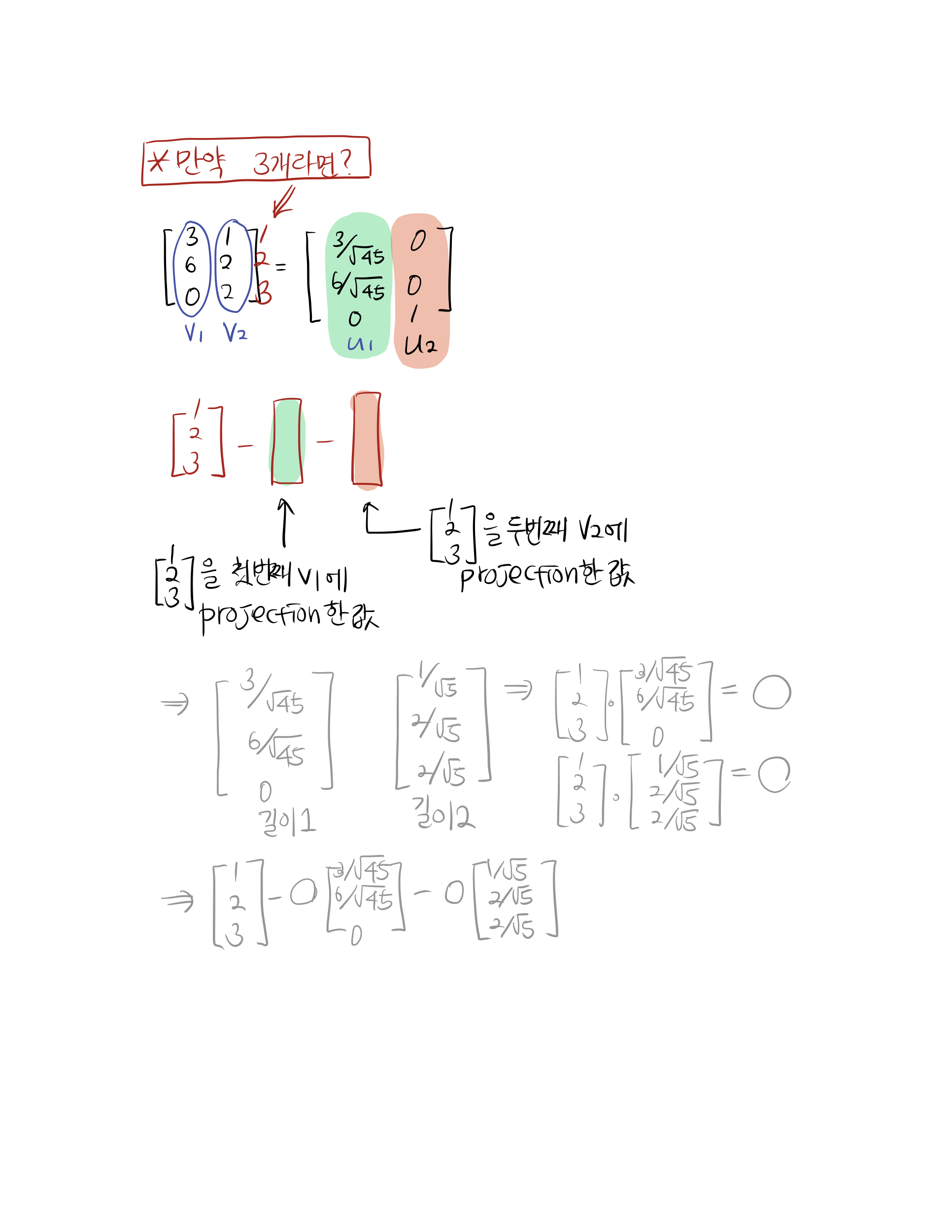

만약 3개라면? 다음과 같다. 이 것을 기본으로 일반화 된 공식으로 확장된다.

정리

먼저, Gram-Schmidt Orthogonalization 을 배우는 목적을 알아두자. feature 간 Orthogonal 이 되지 않으면 중복된 정보를 추출하게 되기 때문에 linearly independent 한 feature 를 Orthogonal 하게 만들기 위해서 사용한다.

기본적인 projection 연산자를 숙지하자. 마법의 공식...

그람 - 슈미트 직교화에 대해서는 공식과 도출 과정을 알고 있자.

그리고 이렇게 W의 orthogonal한 basis를 찾는 것이 아니라 반대로 orthogonal 한 벡터를 주고 다시 원래의 벡터를 찾는 것을 matrix factorization, input matrix 복원이라고 한다. 다음 글에서 이 QR factorization 을 설명하겠다.

Reference

주재걸 교수님의 인공지능을 위한 선형대수

'🤖 Today-I-Learned ] > Statistics & Machine Learning' 카테고리의 다른 글

| [선형대수] 고유값과 고유벡터 (eigenvector & eigenvalue) (0) | 2021.02.12 |

|---|---|

| [선형대수] QR분해 (QR Factorization) (0) | 2021.02.02 |

| [선형대수] 다중공선성 (Multicollinearity) 의 기하학적 의미 (0) | 2021.01.26 |

| [선형대수] Orthogonal Projection ŷ of y (0) | 2021.01.26 |

| [선형대수] 딥러닝에서의 일대일 대응 (ONE-TO-ONE) (0) | 2021.01.25 |

그람-슈미트 직교화 (Gram–Schmidt Orthogonalization)

먼저, Gram-Schmidt Orthogonalization, 왜 배우는 걸까?

feature 간 수직 (Orthogonal)이 되지 않으면 중복된 정보를 추출하게 된다.

-> linearly independent 한 feature를 Orthogonal 하게 만들자!

이전 글(Orthogonal Projection)에 포스팅한 마법의 공식, 다시 등장한다. projection 의 공식이다. 위키피디아에서는 사영 연산자를 다음과 같이 정의한다.

그람-슈미트 과정의 일반화 된 공식은 아래와 같다. 이 공식을 도출해보자.

예제

먼저 2차원에서는 쉽다.

Let W = span{v1, v2}, where v1 = [3,6,0].T and v2 = [1,2,2].T 일 때 W에 orthogonal basis {u1, u2} 를 만들어보자.

공식에 대입해도 바로 나온다.

예제

만약 3개라면? 다음과 같다. 이 것을 기본으로 일반화 된 공식으로 확장된다.

정리

먼저, Gram-Schmidt Orthogonalization 을 배우는 목적을 알아두자. feature 간 Orthogonal 이 되지 않으면 중복된 정보를 추출하게 되기 때문에 linearly independent 한 feature 를 Orthogonal 하게 만들기 위해서 사용한다.

기본적인 projection 연산자를 숙지하자. 마법의 공식...

그람 - 슈미트 직교화에 대해서는 공식과 도출 과정을 알고 있자.

그리고 이렇게 W의 orthogonal한 basis를 찾는 것이 아니라 반대로 orthogonal 한 벡터를 주고 다시 원래의 벡터를 찾는 것을 matrix factorization, input matrix 복원이라고 한다. 다음 글에서 이 QR factorization 을 설명하겠다.

Reference

주재걸 교수님의 인공지능을 위한 선형대수

'🤖 Today-I-Learned ] > Statistics & Machine Learning' 카테고리의 다른 글

| [선형대수] 고유값과 고유벡터 (eigenvector & eigenvalue) (0) | 2021.02.12 |

|---|---|

| [선형대수] QR분해 (QR Factorization) (0) | 2021.02.02 |

| [선형대수] 다중공선성 (Multicollinearity) 의 기하학적 의미 (0) | 2021.01.26 |

| [선형대수] Orthogonal Projection ŷ of y (0) | 2021.01.26 |

| [선형대수] 딥러닝에서의 일대일 대응 (ONE-TO-ONE) (0) | 2021.01.25 |